Pochi minuti fa parlavamo delle elevate prestazioni che abbiamo riscontrato nella NPU Hexagon del nuovo Qualcomm Snapdragon 8 Gen 2, Prestazioni più elevate che consentono persino di differenziare più articoli in tempo reale per elaborarli separatamenteMa la verità è che le sorprese non finiscono qui, poiché l’azienda ci ha sorpreso con un’altra nuova tecnologia in questo SoC.

Questa funzione è chiamata Inferenza sulle tessere piccoleche consente al chip di dividere le attività di inferenza in livelli più piccoli, Consentire l’uso delle tre NPU (Tensor, Scalar e Vectorial) per velocizzare le attività che lo consentono Esegui ciò che può essere efficacemente elaborato in parallelo, cosa che prima era impossibile perché queste attività non possono essere suddivise in attività più piccole e indipendenti.

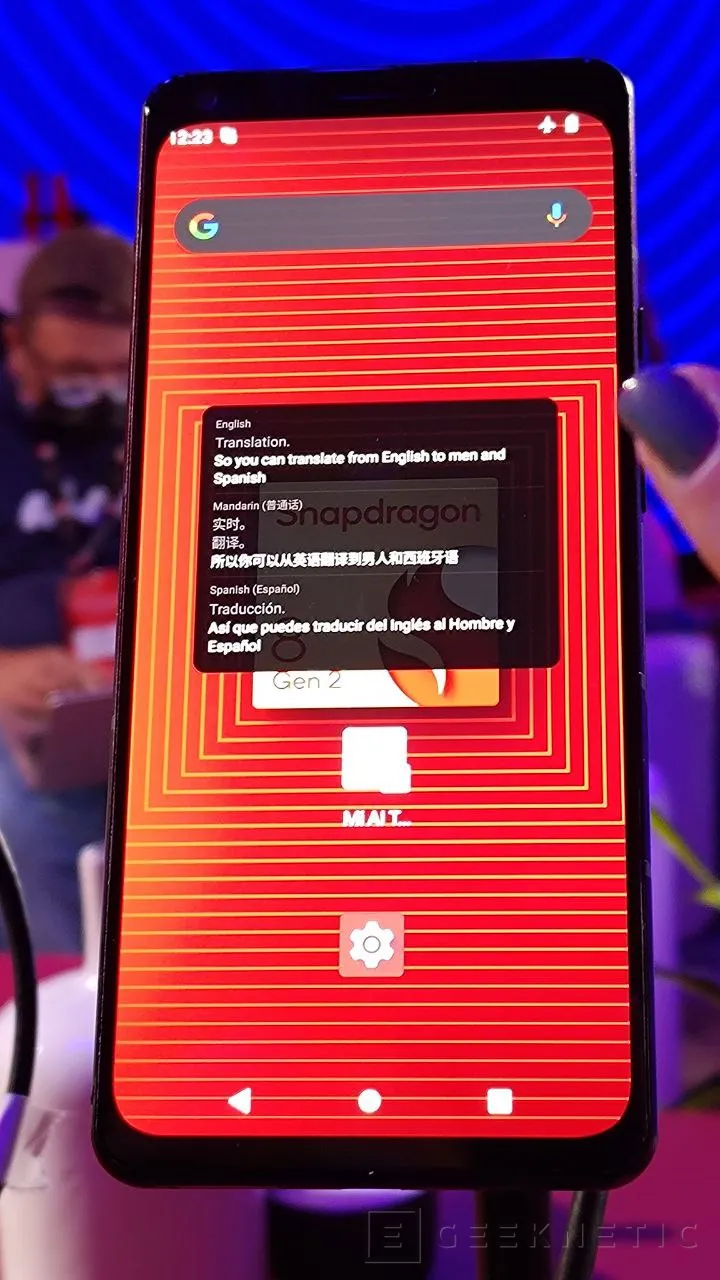

In linea di principio, questa tecnologia di elaborazione può essere applicata a tutte le attività che una NPU deve eseguire, perché sebbene possiamo vedere come viene eseguito l’hashing semantico in tempo reale, È stato anche possibile assistere a una demo in cui l’audio viene trascritto istantaneamente in testo in due linguecosa che prima non era possibile.

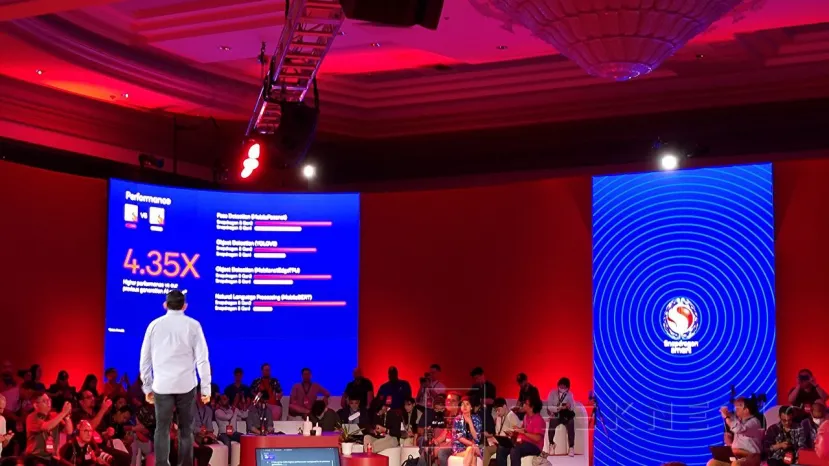

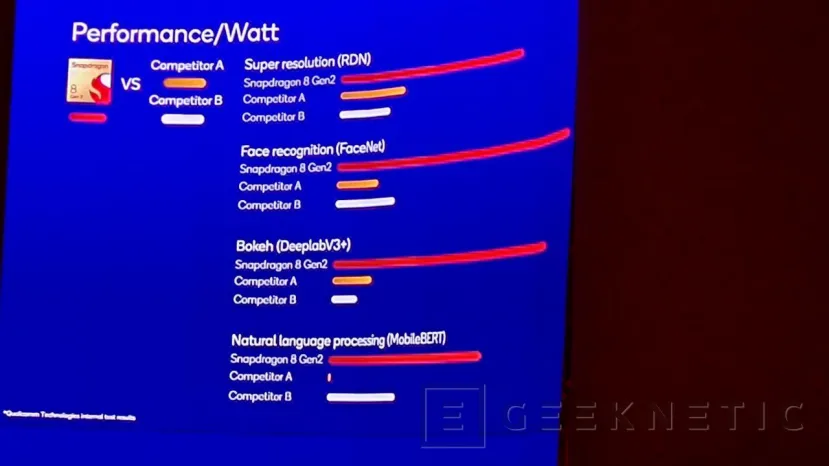

In tutto, abbiamo riscontrato un miglioramento delle prestazioni di oltre 4 volte rispetto ad altri chip Qualcomm, il che non è affatto un miglioramento insignificante, E questo, rispetto alla concorrenza, dimostra sicuramente l’importanza di questa tecnologia.

La fine dell’articolo. Raccontaci qualcosa nei commenti!

Jordi Brishall

Appassionato di tecnologia ed elettronica. Ho giocherellato con i componenti del computer quasi da quando potevo camminare. Ho iniziato a lavorare in Geeknetic dopo aver vinto un concorso sul loro forum per scrivere articoli sull’hardware. Amante del drifting, della meccanica e della fotografia. Sentiti libero di lasciare un commento sui miei articoli se hai qualche domanda.

“Educatore generale della birra. Pioniere del caffè per tutta la vita. Sostenitore certificato di Twitter. Fanatico di Internet. Professionista dei viaggi.”